利用するデータや知識の質,量,バイアスなどにより,AIも間違うことがある.しかし,ほとんどのエンドユーザは,思い込みや偏見からAIの性能を正当に評価できず,AIの出す解を闇雲に受け入れたり,拒否する傾向が強い.このAI性能評価エラーは,人間-AI協調意思決定の本質的問題であり,その解決は信頼されるAIにとってのグランドチャレンジである.

我々は,インタラクション研究で得られた知見から,この問題を解決し,人間-AI協調意思決定が人間の満足を得てベストパフォーマンスを出すには,従来のようなAI自体の性能向上を目指すだけでは難しく,人間とAIがインタラクションを通して,AI性能を正確に評価可能になる信頼の最適化と主体的な信頼最適化により得られる納得感が必要という結論に至った.

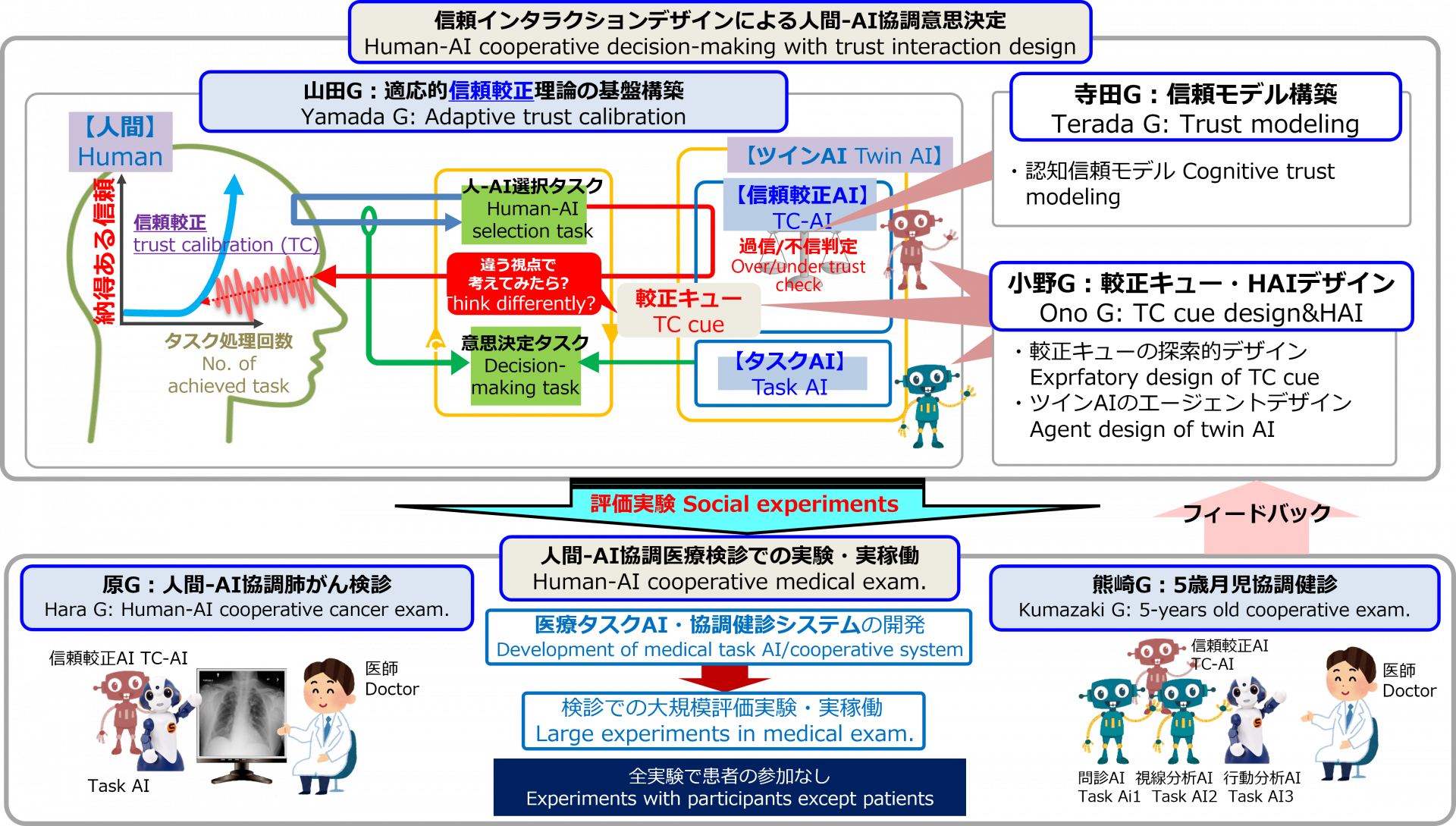

以上の背景から本提案では,『AIが人の認知バイアス,価値観を基に信頼関係の崩れ(過信/不信)を検出し,適応的に較正キューを出して信頼較正を促すことで,信頼関係を最適化し納得感を向上させる信頼インタラクションデザインの理論構築と社会浸透を図る』具体的には,人間-AI協調が必須な医療検診・健診における実装で社会浸透を目指す.

なお,本手法は人の意思決定を誘導する可能性があり,実験と実稼働での倫理的検討が不可欠のため,倫理観モデル導入とシステム設計の透明性担保による技術的解決,AI利用のオプトインによる実験・実稼働での解決,学会連携による社会的解決により検討する.

ここでは信頼工学での定義を拡張し,諸概念を下記のように定義する.また,人間-AIの最適信頼のための提示タイミングの決定と較正キューのデザインを信頼インタラクションデザインと呼ぶ.

- 信頼 (trust):タスク成功確率

- 最適信頼 (optimal tsust):信頼の真値

- 過信/不信 (over trust/under trust):信頼の過大/過小推定

- 信頼較正 (trust calibration):人間が自分のAIに対する信頼を修正して最適信頼を得ること.

本提案の概念,G(グループ)の組織・連携を図1に示す.人間-AI協調意思決定では,自分で意思決定を遂行するか/AIに任せるかを人間が決定,実行を繰り返す(ツインタスク).そして,信頼較正AIが信頼モデルを基に人間とAIの信頼を計算し,その大小関係から決定する合理的選択と実際の人間の選択を比較,過信・不信を検知する.

検知されれば,信頼較正を促す較正キュー(図1の『違う視点で考えてみたら?』)を表出する.人間は較正キューに反応して自らの意思で信頼較正を行うため,人は納得感を持って最適信頼を構築できる.

信頼較正AIとタスク遂行するタスクAIからなるツインAIが本提案の中心的成果であり,タスクAIを入れ替えて様々な分野に応用可能な基盤技術である.さらに,社会的価値の大きな人間-AI協調検診へ応用,大規模評価実験と社会浸透を目指す.

提案テーマ全体は,以下の5研究Gと個別の研究テーマのもとに遂行される(図1).

山田G:適応的信頼較正理論の基盤構築:上記,適応的信頼較正の理論基盤を確立し,さらに意思決定理論への一般化を遂行する.また,原,熊崎GのツインAI開発をサポートする.

寺田G:信頼モデル構築・学会連携:構造方程式モデリングと機械学習により,人間の認知信頼モデルとAI信頼モデルを開発する.また,学会の倫理委員会と連携したシンポジウム・タウンミーティングを通じて社会面からAI導入の倫理的検討を行う.

小野G:較正キュー・HAIデザイン:較正キューの表現,ツインAIデザイン(2体/1体,実機ロボット/仮想エージェント),環境知能への埋め込み等を探索的にデザインし,実験的検証を行う.

原G:人間-AI協調肺がん検診:読影タスクAIを開発し,100名規模の医師の協力を得て,厳密な評価基準により,人間-AI協調肺がん健診の大規模実験を実施,実稼働する.

熊崎G:5歳児協調健診:原GのツインAIにマルチタスクAIを導入し,肺がん検診よりも複雑な処理を要する5歳児協調健診システムを開発し,大規模実験・実稼働を達成する.

- Kazuo Okamura, Seiji Yamada (2020). Empirical Evaluations of Framework for Adaptive Trust Calibration in Human-AI Cooperation. IEEE Access, 1. https://doi.org/10.1109/access.2020.3042556

Kazuo Okamura, Seiji Yamada (2020). Adaptive trust calibration for human-AI collaboration. PLOS ONE, 15(2), e0229132. https://doi.org/10.1371/journal.pone.0229132