Empirical investigation of how robot’s pointing gesture influences trust in and acceptance of heatmap-based XAI

2023-04-10前東 晃礼 Akihiro Maehigashi(静岡大学),福地 庸介 Yosuke Fukuchi(NII),山田 誠二 Seiji Yamada(NII/総研大)

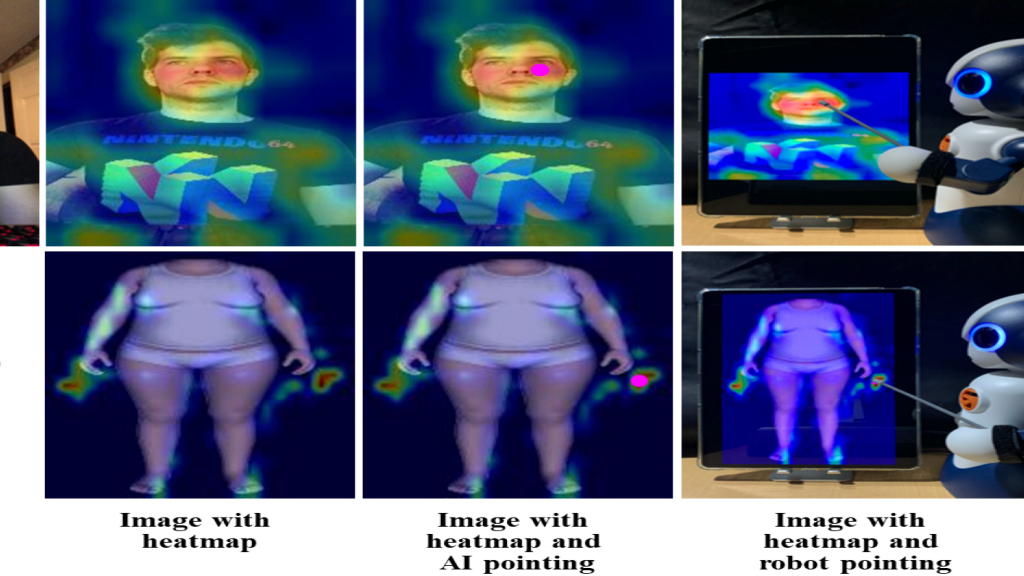

本研究では,ロボットの注意ヒートマップを表示しながらロボットがポイントジェスチャーを行うことが,ロボットの出力に対する人間の信頼や受容にどのような影響を与えるかを検討した.我々は,2種類の視覚タスクを用いた実験を実施した.これらのタスクでは,参加者はAIやロボットの回答を受け入れるか拒否するかを決定する必要があった.参加者は,AI注目ヒートマップ,AIポインティング付きヒートマップ(レーザードットカーソルとして表示),ロボットポインティング付きロボット注目ヒートマップ(棒付きタブレットに表示されたヒートマップの特定の場所をポインティング),またはヒートマップなしで回答を見ることができました.実験の結果,より難易度の高い課題において,ヒートマップの解釈可能性が低い場合,AIとロボットによる注意ヒートマップの指差しが,参加者の回答の受容性を低下させることが明らかになりました.また,ロボットがヒートマップを指差すことで,より難しいタスクでヒートマップの解釈可能性が高い場合,その答えの受容性が高まる可能性が示されました.さらに,ロボットの回答に対する受容性は,ロボットに対する感情的信頼と相関していた.本研究は,ロボットが注目ヒートマップを指し示すジェスチャーを用いることで,人間とロボットの相互作用における人間の行動や感情的信頼を制御できる可能性を示している.

Selectively Providing Reliance Calibration Cues With Reliance Prediction

2023-04-09福地 庸介 Yosuke Fukuchi(NII),山田 誠二 Seiji Yamada(NII/総研大)

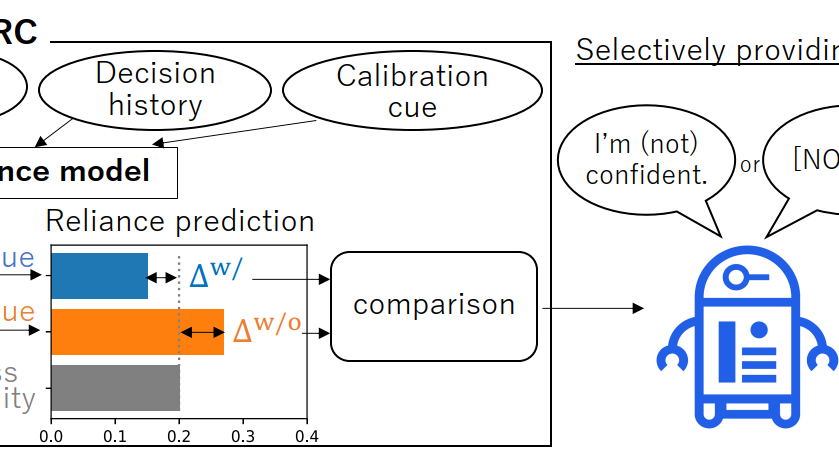

意思決定に機械学習を応用した知的エージェントと人間が効果的に協働するためには,人間がエージェントにできること,できないことを理解し,過不足のない依存を避ける必要があります.この問題の解決策として,人間がエージェントの能力を評価するのに役立つRCC(Reliance Calibration Cue)を用いたコミュニケーションを通じて,人間の信頼度を調整することが挙げられます.これまでの研究では,RCCを継続的に提示することで信頼度を校正することが一般的であったが,エージェントがいつRCCを提供すべきかは未解決のままである.そこで,我々は,RCCを選択的に提供する手法であるPred-RCを提案する.Pred-RCは,認知的信頼性モデルを用いて,人間がエージェントにタスクを割り当てるかどうかを予測する.RCCがある場合とない場合の予測結果を比較することで,RCCが人間の信頼性に与える影響を評価する.Pred-RCを人間とAIのコラボレーションタスクでテストしたところ,RCCの数を減らしても人間の信頼性をうまく較正できることがわかった.

Influence of agent’s self-disclosure on human empathy

2023-03-10津村 賢宏 Takahiro Tsumura (SOKENDAI/NII), 山田 誠二 Seiji Yamada (NII)

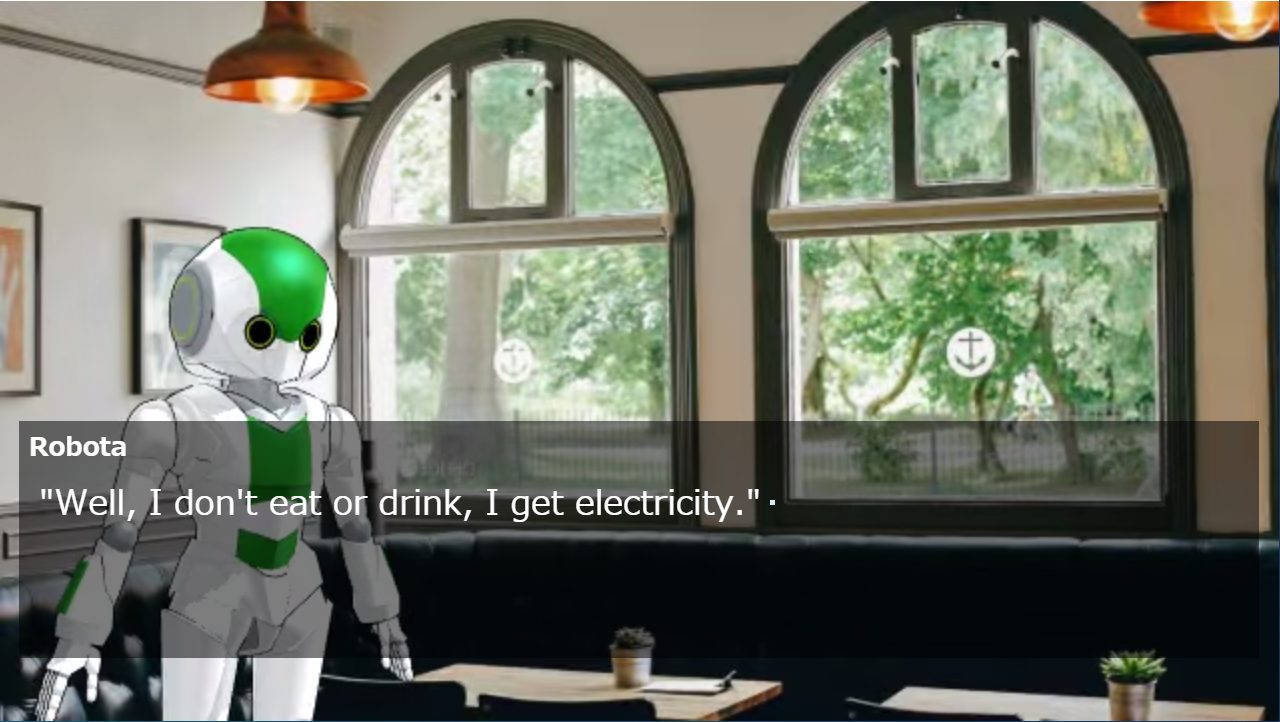

AI技術の進歩に伴い,人間社会にAIをより多く応用するためには,知的なバーチャルエージェントやロボットなどのAIエージェントの社会的受容がより重要になってきている.人間と擬人化されたエージェントの関係を改善する一つの方法は,人間にエージェントに共感してもらうことである.共感することで,人間はエージェントに対してポジティブで親切な行動をとるようになり,エージェントを受け入れやすくなる.本研究では,擬人化されたエージェントに対する人間の共感を高めるために,エージェントから人間への自己開示に着目する.エージェントからの自己開示が人間の共感を促進する可能性を実験的に検討する.仮説を立て,人間がエージェントに対してより多くの共感を得る条件を実験的に分析・考察する.実験は三者混合計画で行い,因子はエージェントの外見(人間,ロボット),自己開示(高関連自己開示,低関連自己開示,自己開示なし),ビデオ刺激の前後での共感とした.918名の参加者のデータを用いて分散分析(ANOVA)を行った.その結果,外見要因には主効果がなく,使用したシナリオとの関連性が高い自己開示は,統計的に有意な差をもって,より人間的な共感を促進することがわかった.また,自己開示がない場合は,共感が抑制されることがわかった.これらの結果は,我々の仮説を支持するものである.本研究により,自己開示は擬人化エージェントの重要な特徴であり,人間が擬人化エージェントを受け入れるのに役立つことが明らかになった.

Modeling Reliance on XAI Indicating Its Purpose and Attention

2023-03-10前東 晃礼 Akihiro Maehigashi (静岡大学),福地 庸介 Yosuke Fukuchi(NII),山田 誠二 Seiji Yamada(NII/SOKENDAI)

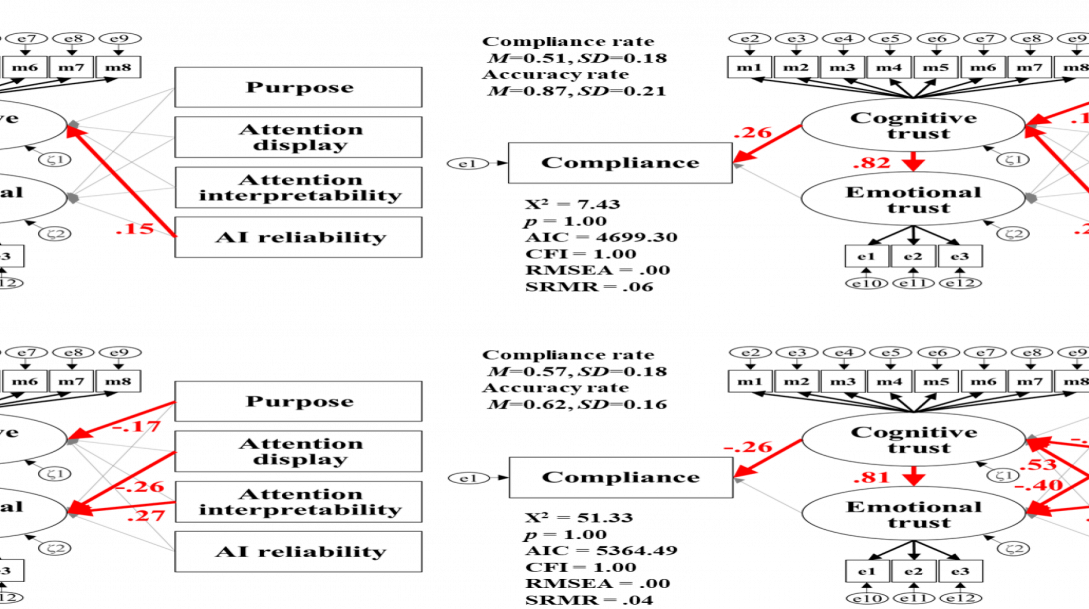

本研究では,そのプロセスの説明として目的や注目度を示すXAIを用い,これらの説明が人間のAIに対する信頼や利用にどのような影響を与えるかを調査した.本研究では,AIの注意を示すヒートマップを生成し,ヒートマップの解釈可能性の妥当性を確認する実験1を行い,目的およびヒートマップが依存(AIに依存する)および遵守(AIの回答を受け入れる)に与える影響を調べる実験2を実施した.構造方程式モデリング(SEM)分析の結果,(1)AIの利用目的表示は,AIの利用形態,依存・遵守,タスクの難易度によって信頼に正負の影響を与えること,(2)より難しいタスクではヒートマップを表示するだけで信頼に負に影響,(3)より難しいタスクではヒートマップの解釈性によって信頼に正の影響を与えることがわかった.

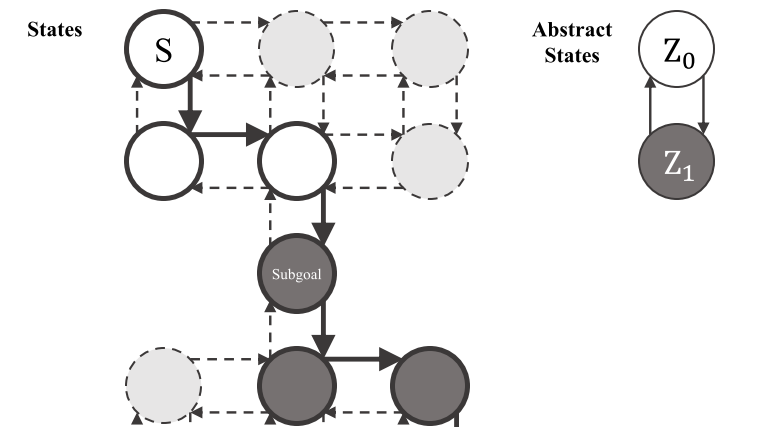

Learning Potential in Subgoal-Based Reward Shaping

2023-02-16奥戸 嵩登 Takato Okudo (総研大 SOKENDAI),山田 誠二 Seiji Yamada(NII/SOKENDAI)

人間の知識は,強化学習において学習に必要な反復回数を減らすことができる.最も一般的なアプローチは軌跡を用いるものであるが,ドメインによっては軌跡を取得することが困難な場合がある.そこで,軌跡の代わりに中間状態であるサブゴールが研究されている.サブゴールに基づく報酬整形は,環境報酬にサブゴールの並びで報酬を追加する手法である.サブゴールベースのリワードシェーピングの構成要素であるポテンシャル関数は,その出力を制御するハイパーパラメータによって形作られる.しかし,ハイパーパラメータの適切な値は環境の報酬関数に依存し,報酬関数は未知であるがその出力は利用できるため,ハイパーパラメータの選択は容易でない.そこで,ハイパーパラメータをパラメータ化し,学習によってそのポテンシャルを獲得する学習ポテンシャルを提案する.学習済みポテンシャルとは,エージェントが現在の状態から政策に従った場合に期待される累積報酬であり,報酬関数と強く関連している.学習したポテンシャルを用いて,サブゴールの列を持つ状態の上位表現である抽象状態空間を構築し,抽象状態に対する値をポテンシャルとして用いることで,値の学習を加速させる.Nステップの時間差分(TD)法は,抽象的な状態上の値を学習する.学習したポテンシャルの有効性を評価するために実験を行った結果,ベースラインの強化学習アルゴリズムや複数の報酬形成アルゴリズムと比較して有効であることが示された.また,学習済みポテンシャルを用いてランダムに生成されたサブゴールよりも,参加者のサブゴールの方が優れていることが示された.学習済みポテンシャルに適したサブゴールの数,部分的に順序付けられたサブゴールは学習済みポテンシャルにとって有用であること,学習済みポテンシャルはステップペナルティ付き報酬において学習を効率化できないこと,正負混合報酬において学習済みポテンシャルは非学習済みポテンシャルよりも優れていることを議論する.

Identifying Visitor’s Paintings Appreciation for AI Audio Guide in Museums

2023-02-10斉藤 真理 Mari Saito (SONY), 奥戸 嵩登 Takato Okudo (SOKENDAI), 山田 真 Makoto Yamada (SONY), 山田 誠二 Seiji Yamada (NII/SOKENDAI)

本稿では,利用者が美術鑑賞に取り組んでいるかどうかを予測する機械学習を応用し,案内を行うタイミングを自動制御できるAI音声ガイドシステムを開発した事例を紹介する.美術館におけるインテリジェントな音声ガイドに関する研究は数多く行われているが,来館者が美術鑑賞に取り組んでいるときに自動的に音声ガイドの再生を開始するAI音声ガイドシステムの開発を試みた例は少ない.本論文では,美術館で識別される利用者が美術鑑賞に従事しているかどうかという2つのクラスを分類することで,音声ガイドを開始するタイミングを決定する.この分類に時系列データに対する教師あり機械学習を適用する.実際の美術館で参加者を対象に実験を行い,参加者の頭部の姿勢や動作のラベル付き時系列データを学習データとして収集しました.そして,時系列データに対する分類学習アルゴリズムを適用して,参加者が絵画鑑賞に関わるタイミングを予測し,モデル選択を行い,収集したデータでモデルを実験的に評価した.その結果,82%以上の高い精度が得られたことから,機械学習を用いた絵画鑑賞のリアルタイム識別が,AI音声ガイドシステムにおいて有望であることが確認されました.

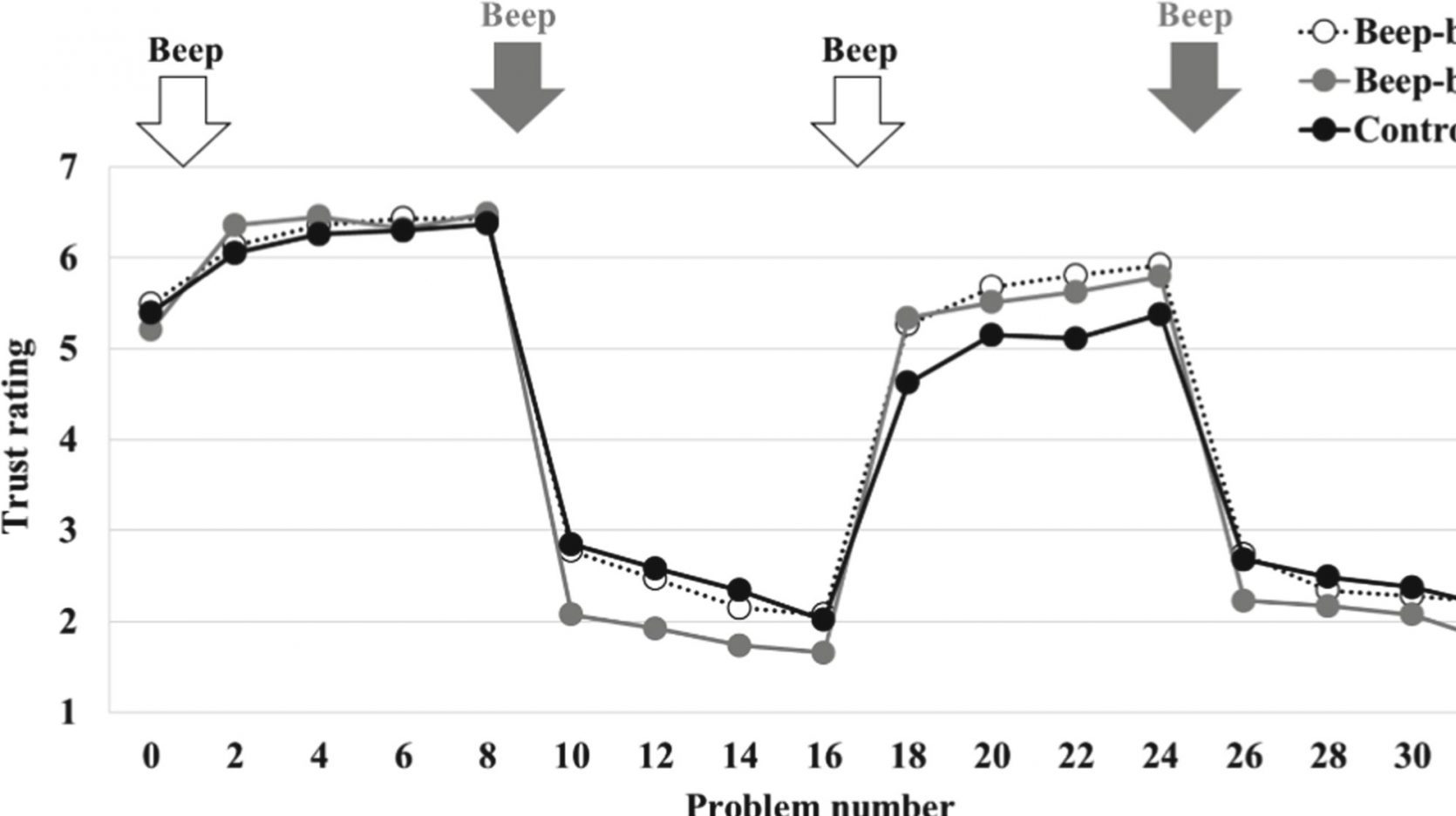

Effects of Beep-Sound Timings on Trust Dynamics in Human-Robot Interaction

2022-10-10前東 晃礼 Akihiro Maehigashi (静岡大学),津村 賢宏 Takahiro Tsumura (SOKENDAI/NII),山田 誠二 Seiji Yamada(NII/SOKENDAI)

本研究では,社会的ロボットの擬人化と機械的特徴の組み合わせが人間の信頼に与える影響を調査した.特に,擬人化された身体性を持つ社会的ロボットが発するビープ音が,人間のロボットに対する信頼にどのように影響するかに注目した.ビープ音は,ロボットがタスクパフォーマンスの高低を示す直前に提示されるように実験的に操作された.その結果,(1)高パフォーマンス直前の音は,ロボットが正確に動作したときの信頼を高め,(2)低パフォーマンス直前の音は,ロボットが不正確に動作したときの信頼をより低下させ,また正確に動作したときの信頼をより高めることがわかった.また,同じビープ音を提示しても,タイミングによって人間の信頼感に与える影響が異なることがわかった.この結果をもとに,人間とロボットのインタラクションにおける信頼をデザインするための可能な方法について議論する.

t/

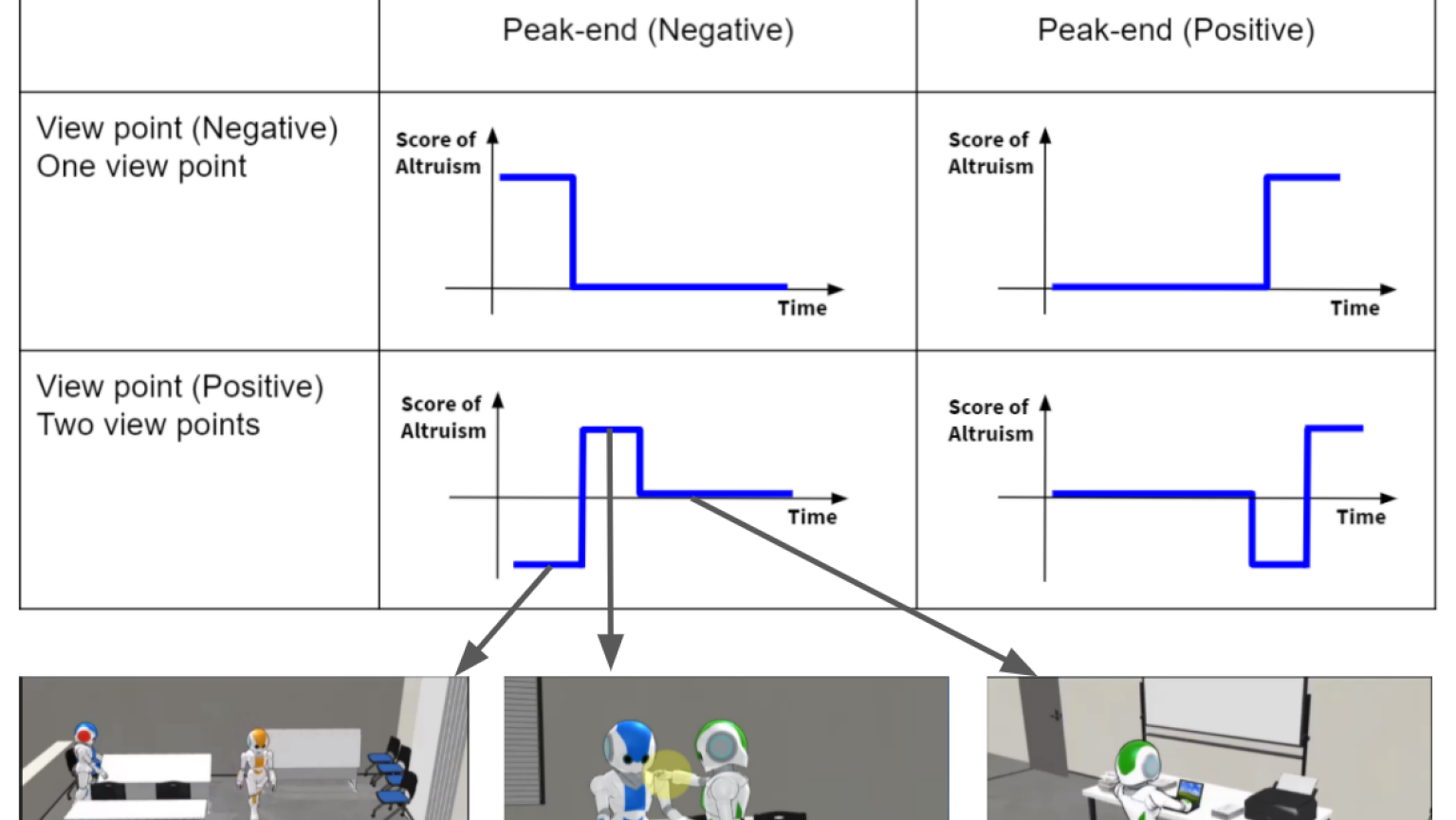

Designing Nudge Agents that Promote Human Altruism

2022-10-03コウ チンリン Chenlin Hang (SOKENDAI), 小野 哲雄 Tetsuo Ono (Hokkaido University) & 山田 誠二 Seiji Yamada (NII)

これまでの研究で,人間と人間の相互作用において,ナッジングが利他主義を促進する鍵であることが判明しています.しかし,社会的ロボットにおいては,ナッジングが利他主義に与える効果を確認する研究はまだ少ないのが現状である.本論文では,ソーシャルロボット(仮想エージェント)が行う映像刺激に対して,ピークエンドと多視点という2つのナッジメカニズムを適用し,刺激の微妙な変化で人間の利他主義を促進できるかどうかを検証する.実験は,136名の参加者を対象に,クラウドソーシングによりオンラインで行われた.その結果,映像の最後に設定されたピークパートを見た参加者は,独裁者ゲームの成績が良く,ピークエンド効果によるナッジメカニズムが実際に人間の利他主義を促進したことがわかった.